인공지능의 윤리, 결국 사람 사이의 문제

-

기사 스크랩

-

공유

-

댓글

-

클린뷰

-

프린트

이상은 기자의 Global insight

자율자동차·로봇 설계자도 인간

무한 신뢰·무한 책임 어려워

새 AI 윤리, 사회적 합의 필요

자율자동차·로봇 설계자도 인간

무한 신뢰·무한 책임 어려워

새 AI 윤리, 사회적 합의 필요

에릭 호르비츠 전 인공지능발전협회(AAAI) 회장이 이런 프로젝트가 필요하다는 아이디어를 냈다. 학계와 산업계의 AI 관련 연구진 17명이 지난 한 해 동안 ‘2030년의 보통 북미 도시 거주자에게 AI로 인해 어떤 변화가 생길까’를 주제로 논의했다.

이세돌 9단이 지난 3월 구글의 AI ‘알파고’와 바둑 대결에서 진 뒤로, 그렇지 않아도 불안해하던 사람들의 마음속에는 AI에 대한 공포가 더 커졌다. “로봇이 뭘 해도 사람보다 낫지 않을까. AI가 ‘깨어나서’ 터미네이터의 스카이넷(인간을 공격하는 AI)이 현실화될지도 모른다!”

그러나 긍정적인 면 일색인 보고서에 대한 비판적 시각도 존재한다. AI 기술개발을 주도하는 몇몇 대기업의 관점에 포섭돼 있다는 것이다. 스탠퍼드대에 보고서를 만들자며 돈을 끌어온 호르비츠는 마이크로소프트(MS) 연구원이다.

기업들이 직접 AI 이슈를 주도하고 여론에 영향을 주려는 움직임은 뚜렷하다. 뉴욕타임스(NYT)는 스탠퍼드대 보고서 발표 시기와 맞물려 구글 모회사인 알파벳, 아마존, 페이스북, IBM, MS 등 5개 정보기술(IT) 대기업 연구진이 최근 AI 관련 단체를 설립하기 위한 모임을 가졌다고 보도했다.

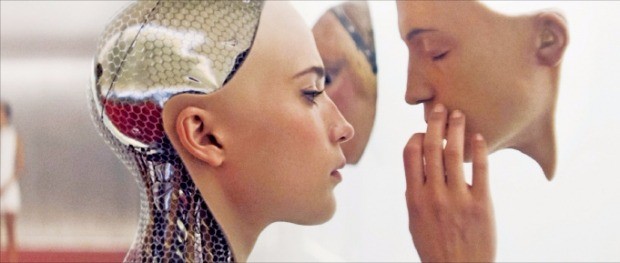

물론 AI에 대한 공포는 지나친 점도 있다. 소설이나 영화와 달리 실제로 ‘AI가 자의식을 갖는 문제’를 고민하는 과학자나 공학자는 거의 찾아볼 수 없다. 스튜어트 러셀 미국 UC버클리 컴퓨터과학과 교수는 “AI의 주류 분야에서 자의식이나 감정을 연구한 논문은 단 한 편도 없다”고 지적했다.

스카이넷은 아직 떠올릴 필요가 없다. 그보다도 AI 윤리에 관한 논의가 본격화되는 지금 우리가 생각해야 하는 것은 자율주행차나 로봇처럼 ‘인간이 설계한 머리(AI)’에 얼마나 판단 권한과 책임을 부여할 것인가다. AI 알고리즘 개발자는 신이 아니고 인간이며, AI 이용자도 인간이다. 양쪽 모두 완전히 신뢰할 수도 없고 둘 중 하나만 무한책임을 지라고 하기도 쉽지 않다. 결국 사람 사이의 문제다. AI 윤리에 관한 논의를 ‘그들만의 리그’로 남겨두어선 안 될 것 같다.

이상은 기자 selee@hankyung.com

!["퀄리티 정말 미쳤다"…유튜브 뜬 日미소녀에 '초긴장' [영상]](https://img.hankyung.com/photo/202411/01.38715246.3.gif)

![[포토] SKB "동화책, 애니메이션으로 즐겨요"](https://img.hankyung.com/photo/202411/AA.38714473.3.jpg)