네이버, 읽어주는 웹툰 서비스 개발

SK텔레콤은 일상·업무용 시각 지원 앱

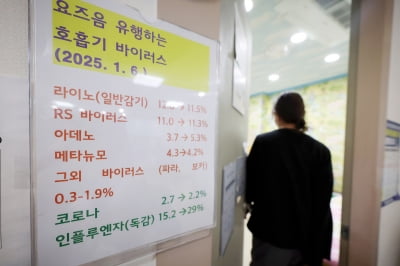

이같이 매우 중요하고, 제 기능을 잃기도 쉬운 시각 기능을 지원하기 위해 주요 정보통신기술(ICT) 기업들은 인공지능(AI) 기술을 활용하고 있습니다. 일상·업무·취미 등 생활 각 측면에 걸쳐 시각장애인과 저시력자를 위한 서비스가 잇따라 나오고 있습니다.

내년 1월 ‘읽어주는 웹툰’ 나온다

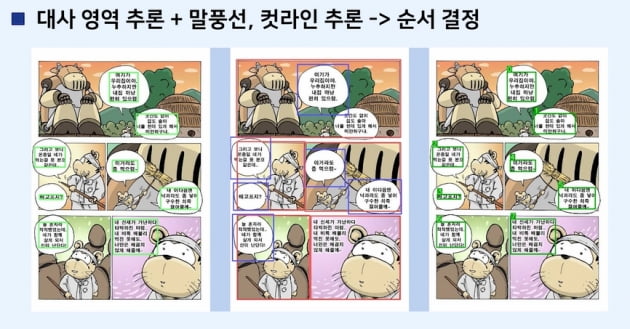

네이버의 콘텐츠 플랫폼 자회사 네이버웹툰은 지난 5일 AI를 활용한 웹툰 서비스 ‘배리어프리 웹툰’을 개발했다고 발표했습니다. AI가 웹툰 말풍선 속 문장을 인식해 등장인물 대사를 읽어주는 서비스입니다. 이를 통하면 시각장애인도 라디오 드라마를 듣는 것처럼 웹툰 내용을 즐길 수 있습니다. 네이버는 이 서비스를 내년 1월부터 자사 플랫폼 내 웹툰 총 18만 회차에 시범 적용합니다.기존에도 문장을 읽어주는 서비스는 많지만, 웹툰엔 적용하기가 어려웠습니다. 뉴스나 웹소설 등과는 달리 단순히 화면에 뜬 글을 한 목소리로 줄줄이 읽는 게 아니기 때문입니다.

시각장애인이나 저시력자에게 웹툰 내용을 전달하려면 컷(웹툰 그림의 단위)마다 대사와 배경 효과음, 해설 등을 따로 구별하고 순서도 매겨야 합니다. 주인공이 단순히 앞을 지나가는 건물 간판처럼 배경에 나오는 텍스트는 따로 읽지 않고 넘어갈 수도 있어야 합니다. '

네이버웹툰이 이같은 서비스에 나서는 이유는 콘텐츠 소외층을 줄이기 위해서입니다. 약 15년전(네이버웹툰의 초기 유명작 ‘마음의소리’는 2006년 하반기에 시작했습니다)엔 웹툰이 젊은 이용자 일부가 보는 콘텐츠였지만 요즘은 다릅니다. 웹툰 속 장면이나 대사가 유행어에 쓰이는 일이 예사일 정도로 많은 이들이 즐기는 대중문화 장르가 됐습니다. 웹툰이 단순히 ‘안 보이면 안 보면 되지’라고 할 수 있는 콘텐츠가 아니라는 얘기입니다. 네이버는 시범 적용 후 서비스 회차와 언어를 확대하고, 적용 기술도 꾸준히 고도화할 계획입니다.

업무·일상용 시각 지원 AI도

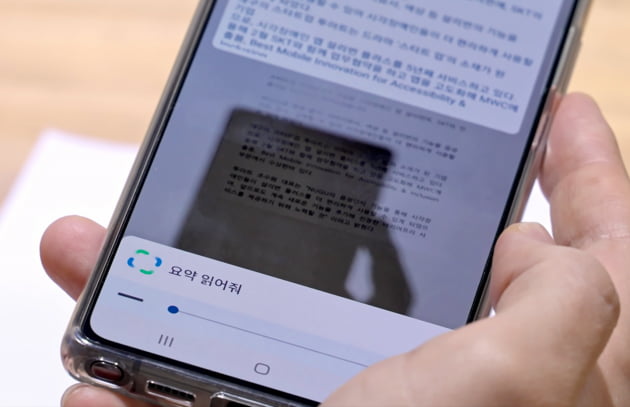

SK텔레콤은 시각 지원 AI 서비스 앱을 일상용과 업무용 둘로 나눠 개발·운영하고 있습니다. 일상용 앱인 설리번플러스는 스마트폰 카메라를 통해 사람·글자·사물·색상 등을 인식한 뒤 음성 안내를 해줍니다.기능을 ‘한줄 요약’하면 간단해 보이지만, 시각장애인이나 저시력자, 색약자 등에게는 일상 생활에 큰 도움이 될 수 있는 서비스입니다. 면접장에 가기 전 단정한 옷을 찾는 색약자에게 ‘지금 들고 있는 스웨터는 바탕은 녹색이고, 붉은색 줄무늬가 있습니다’ 등을 알려주는 식입니다. 앱을 쓰는 이들이 식음료의 유통 기한 등도 쉽게 확인할 수 있습니다.

후속으로 나온 시각 지원 AI 앱인 설리번A는 업무 기능에 보다 특화했습니다. 서류 내용을 읽고 요약·정리해주고, 명함을 찍어 이메일을 보낼 수 있게 해줍니다. 영수증을 인식해 요약 정보, 품목 정보, 금액 등 필요한 정보만을 선별해 확인할 수 있는 기능도 탑재됐습니다. 이들 기능은 모두 음성 대화 방식으로 이용할 수 있습니다.

화면 해설 방송은 시각장애인이나 저시력자를 위해 해설자가 대사 외에 부가적인 내용을 음성으로 설명해주는 방송입니다. 등장인물 A와 B가 대화하는 장면에 앞서 ‘기쁜 얼굴을 한 A가 문을 열고 들어온다’ 등을 말로 설명해주는 식인데요. 해설 음성을 따로 녹음한 뒤 기존 음성과 믹싱하는 과정을 거쳐야 해 기존엔 주요 프로그램에만 주로 적용됐습니다. 하지만 AI를 쓰면 기존보다 훨씬 빠르고 효율적으로 화면 해설 방송을 만들 수 있다는 게 CJ올리브네트웍스의 설명입니다.

“‘5kg 미만 하얀 개’ 보다 ‘귀여운 하얀 강아지’ 설명이 낫다”

시각 지원 AI 기술은 '사회·내용적 맥락'을 반영해야 한다는 게 AI 연구계의 최근 지적입니다. 일반적으로는 AI의 설명이나 안내가 객관적인 실체를 반영하는 게 더 중요하지만, 저시력자 등을 위한 해설 서비스는 오히려 그 반대여야 한다는 겁니다.미국 스탠포드대 산하 연구소인 인간중심AI연구소(HAI)도 최근 이같은 내용을 담은 자료를 발간했습니다. 스탠포드대 컴퓨터과학과를 비롯해 구글의 딥러닝 AI 연구팀 구글 브레인, 스탠퍼드 언어학과 교수 등이 실제 시각장애인 설문조사 등을 거쳐 만든 연구 자료인데요. 기존 컴퓨터 과학 분야에서 이미지를 기반으로 텍스트 정보를 생성하는 모델과 실제 시각장애인·저시력자가 유용하다고 생각하는 모델 사이에 간극이 크다는 게 주요 내용입니다.

스탠포드대 HAI는 일반·객관적인 키워드만 나열하는 AI 설명보다 맥락을 반영하는 AI 설명이 필요하다고 주장합니다.

시각장애인에게 강아지 사진을 설명할 때 ‘무게가 5kg 미만으로 추정되는 하얀 개가 들판에서 뛰고 있다. 미국 일리노이주에서 찍은 사진.’ 이라고 하기보다는 ‘귀여운 하얀 강아지가 기쁜 표정으로 꼬리를 흔들며 들판에서 뛰고 있다. 날씨는 화창하다’라고 하는 게 더 효과적이라는 얘기입니다.

스탠포드대 팀 등은 시각장애인과 저시력자 등을 위한 AI 모델 척도를 개발할 계획입니다. 앞으로 또 어떤 시각 지원 AI 기술이 나올지 궁금해집니다.

선한결 기자 always@hankyung.com

![비대면의 시대 '최고원격책임자' 주목…교촌치킨도 드론 배달 [Geeks' Briefing]](https://img.hankyung.com/photo/202212/01.32066233.3.jpg)

![[단독] "5년치 일감 쌓여"…미국서 '돈벼락' 맞은 한국 기업](https://img.hankyung.com/photo/202501/AA.39209575.3.jpg)