한국어 능력 높인 GPT-4…네이버·카카오 '긴장'

-

기사 스크랩

-

공유

-

댓글

-

클린뷰

-

프린트

한때 GPT-4는 GPT-3의 매개 변수(파라미터) 규모인 1천750억개를 아득히 뛰어넘은 1조개 이상의 매개 변수를 갖출 것이라는 추정이 나왔지만, 오픈AI는 GPT-4 매개 변수 규모를 공개하지 않았다.

다만 업계에서는 확실히 '더 똑똑한 모델'이라는 평가가 나온다. 이미지를 보고 이해할 수 있게 됐고, 언어 구사 능력과 기억력이 높아진 것은 물론 영어 이외의 외국어 실력도 전반적으로 향상됐다는 점에서다.

오픈AI에 따르면 GPT-4는 기존 GPT-3.5와 달리 텍스트뿐 아니라 이미지까지 여러 데이터 형태를 인식하는 멀티모달(복합 정보 처리) 모델이다.

문자로만 대화할 수 있었던 데서 사진과 문자를 결합한 질문도 이해하고 답변할 수 있게 발전한 것이다. 계란과 밀가루, 버터, 우유 사진을 올리고 "이걸로 요리할 수 있는 게 뭐지?"라고 물으면 "팬케이크나 와플, 프렌치토스트 등등"이라고 답하는 식이다.

언어 능력 자체도 향상됐다. 처리할 수 있는 단어량은 2만 5천 단어로 챗GPT보다 약 8배 늘어났다. GPT-4는 미국 모의 변호사 시험에서 90번째, 대학 입학 자격시험인 SAT 읽기·수학 시험에서는 각각 93번째와 89번째의 백분위수를 기록했는데 이는 상위 10% 수준이라고 오픈AI는 설명했다.

대화 내용을 기억할 수 있는 능력도 대폭 늘어났다. 미국 정보기술(IT) 전문 매체 테크크런치는 "GPT 3.5는 책 4∼5페이지에 해당하는 4천96 토큰(메모리 단위)을 보유했는데, GPT-4는 최대 책 50페이지 수준인 3만2천768 토큰을 보유했다"면서 "희곡이나 단편 하나를 통째로 외울 수 있다는 의미"라고 소개했다.

특히 GPT-3.5의 고질적 문제였던 '할루시네이션(환각) 현상'도 크게 줄었다고 오픈 AI는 설명했다. 이는 AI가 틀린 정보나 무의미한 내용을 마치 환각을 보는 듯이 그럴듯하게 제시하는 현상이다.

오픈AI는 "GPT-4는 내부 사실성 평가에서 최신 GPT-3.5보다 40% 높은 점수를 받았다"고 했다.

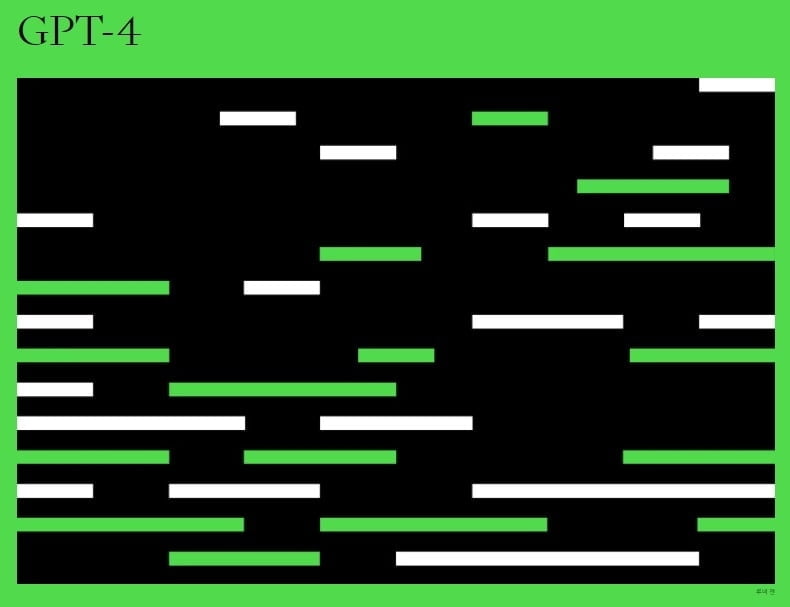

한국어를 비롯한 비영어 언어 성능이 높아진 점도 주목된다. 오픈AI가 시험한 26개 언어 가운데 GPT-4는 한국어와 일본어, 프랑스어 등 24개 언어에서 GPT-3.5가 영어를 하는 수준보다 더 높은 성능을 보였다.

이는 국내에서 생성형 AI를 개발하는 네이버와 카카오 등을 가장 긴장하게 하는 지점이다. 두 회사는 GPT-4가 어떤 반향을 부를지 주목하면서 한국어 특화 대규모 언어모델 개발에 더 집중하겠다는 입장을 밝혔다.

이영호기자 hoya@wowtv.co.kr

!["중국산이라 무시하지 마" 한국 진출 앞둔 BYD 車 타보니… [신차털기]](https://img.hankyung.com/photo/202411/01.38731383.3.jpg)

![다우·S&P500, 사상 최고…서울·수도권 출근길 대설 비상 [모닝브리핑]](https://img.hankyung.com/photo/202411/01.12608176.3.jpg)