"호킹처럼 기계 소리 안 내도 돼"…뇌파로 연주 성공한 美연구진

-

기사 스크랩

-

공유

-

댓글

-

클린뷰

-

프린트

UC버클리대 연구진, 뇌파로 핑크플로이드 대표곡 연주

EEG 활용해 뇌파 신호 포착…AI 기술로 해독 후 재구성

EEG 활용해 뇌파 신호 포착…AI 기술로 해독 후 재구성

16일 가디언 등에 따르면 해당 실험은 이날 국제 학술지 ‘플로스 바이올로지(PLOS Biology)’에 게재됐다.

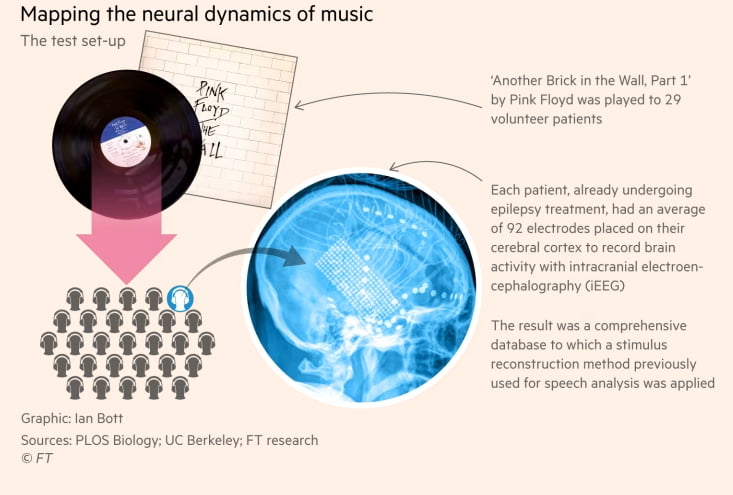

연구팀은 뇌전증(간질) 수술 경험이 있는 29명의 환자에게 영국의 록 밴드 핑크플로이드의 1979년 앨범 ‘더 월’에 실린 수록곡 ‘어나더 브릭 인 더 월(Another Brick in the Wall) 파트 1’을 들려준 뒤 음악을 듣고 있는 동안 이들의 뇌 활동을 분석했다. 두개골 피하에 총 92개의 전극을 삽입해 뇌로부터 나오는 전기 신호를 포착하는 뇌파 검사(EEG)를 활용했다.

연구팀은 AI 기술로 축적된 뇌파 기록을 해독했고, 이를 기반으로 해당 곡에 사용된 단어와 소리를 재구성해낼 수 있었다. 분명하진 않았지만, ‘그저 벽 속의 벽돌이었을 뿐(All in all, it’s just another brick in the wall)’이라는 노래 구절이 알아들을 수 있을 정도로 재현됐다. 연구팀은 뇌의 어느 부분이 리듬을 감지하는지 정확히 짚어낼 수 있었고, 측두엽에 위치한 청각피질 중 음성이 시작되는 지점과 계속되고 있는 부분을 구별해내는 부위가 다르다는 것도 발견했다.

단어 하나하나를 로봇처럼 내뱉는 형식이 아닌, 실제 인간이 말하는 것처럼 자연스러운 언어 표현이 가능할 수 있다는 점에 이번 연구의 의의가 있다는 설명이다. 앞으로는 루게릭병을 앓았던 고(故) 스티븐 호킹 박사처럼 부자연스럽게 소리를 내지 않아도 된다는 얘기다. 나이트 교수와 함께 이번 실험을 주도한 루도비치 벨리에 교수는 “(이번 연구 결과가)노래를 부르고 있지 않을 때도 음성에 색을 입히고, 더 자유롭게 표현할 수 있도록 돕는 데 기여하길 희망한다”고 했다.

이 연구팀은 이전에도 입 밖으로 꺼내지 않고 상상만 했던 단어가 무엇인지 맞추는 데 성공한 적이 있다. 입술과 턱, 혀, 후두 근육의 미세한 움직임을 제어하는 뇌 내 운동 피질의 뇌파를 분석하는 방식을 통해서다. EEG를 활용한 단어 재구성 실험은 2012년에 처음 시작됐고, 10년이 지난 지금에서야 노래의 마디를 재현할 수 있을 만큼 충분한 데이터가 확보됐다고 파이낸셜타임스(FT)가 전했다.

연구팀은 두피 내부로 전극을 삽입하는 작업 없이 단지 EEG와 연결된 모자를 쓰는 방식으로도 뇌파 해독이 가능한 데까지 나아갈 수 있을 것으로 보고 있다. 이게 실현되면 환자가 상상하거나 작곡한 음악이 외부 스피커로 연주되는 것까지 가능해진다는 설명이다. 벨리에 교수는 “비외과적 기술은 아직 충분히 발전되지 않았다”며 “두개골 외부에 부착된 전극에서도 더욱 깊은 곳에서 나오는 뇌파를 감지할 수 있게 되는 날이 곧 오길 바란다”고 말했다.

장서우 기자 suwu@hankyung.com

![K팝 업계에도 '친환경' 바람…폐기물 되는 앨범은 '골칫거리' [연계소문]](https://img.hankyung.com/photo/202206/99.27464274.3.jpg)