KAIST가 결국 해냈다…엔비디아도 깜짝 놀랄 '획기적 기술'

-

기사 스크랩

-

공유

-

댓글

-

클린뷰

-

프린트

엔비디아에 견줄 고용량·고성능 GPU 개발

KAIST는 8일 정명수 전기및전자공학부 교수 연구팀이 차세대 인터페이스 기술인 '컴퓨트 익스프레스 링크(CXL)'가 활성화된 AI 가속기용 고성능 GPU를 개발했다고 8일 밝혔다. 최근 대규모 AI 서비스는 모델과 데이터 크기가 점점 커져 수십 TB(테라바이트·1TB는 1조 바이트)의 메모리를 요구한다. 반면 최신 GPU의 내부 메모리 용량은 수십 기가바이트(GB)에 불과해 단일 GPU만으로는 모델을 추론·학습하는 것이 불가능하다.

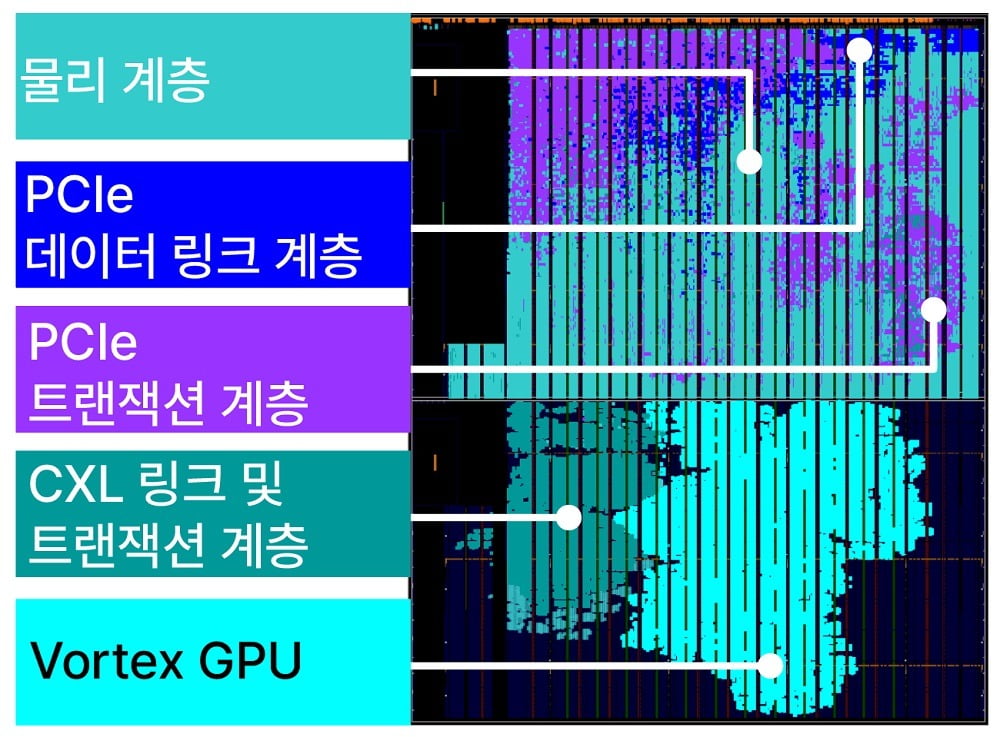

이에 연구팀은 차세대 연결 기술인 CXL을 활용해 대용량 메모리를 GPU 장치에 직접 연결하는 'CXL-GPU' 구조 기술을 개발했다. CXL로 메모리 확장 장치를 GPU 메모리 공간에 통합시켜 GPU를 이어 붙이지 않아도 메모리 용량을 높일 수 있는 기술이다.

다만 CXL-GPU 기술은 그동안 산업계에서 활발히 연구됐지만 메모리 읽기·쓰기 성능이 떨어져 실제로 적용되기 어려웠다. 연구팀은 CXL-GPU 장치의 메모리 읽기·쓰기 성능이 저하되는 원인부터 찾았다. 기존 CXL-GPU는 확장 메모리 장치의 읽기·쓰기가 GPU의 성능을 따라가지 못한다는 것이 문제였다. 연구팀은 메모리 확장 장치가 연결된 GPU에서 신호를 받아 미리 메모리 읽기를 수행하고, 쓰기 타이밍을 스스로 결정하도록 설계했다.

설계된 CXL-GPU는 팹리스(반도체 설계 전문) 스타트업 파네시아에서 시제품을 만들었다. 파네시아는 초고속 CXL 컨트롤러 기술을 자체 개발한 국내 기업이다. 연구팀이 CXL-GPU 시제품을 분석한 결과, 기존 GPU 메모리 확장 기술보다 2.36배 빠르게 AI 서비스를 실행했다. 메모리 용량을 늘리기 위해 더이상 GPU를 대량으로 연결할 필요가 없는 것이다.

연구팀은 개발한 CXL-GPU 기술이 엔비디아의 AI 가속기 시장 독점을 막을 것으로 내다봤다. 정 교수는 "CXL-GPU로 대규모 AI 서비스를 운영하는 빅테크 기업의 메모리 확장 비용을 획기적으로 낮추는 데 기여할 수 있을 것"이라고 말했다. 이번 연구결과는 이번 달 미국 캘리포니아주 산타클라라시에서 열리는 유즈닉스(USENIX) 연합 학회에서 발표될 예정이다.

ADVERTISEMENT

ADVERTISEMENT

![1등만 하던 삼성인데…"상당히 고통스러울 것" 무슨 일이 [황정수의 반도체 이슈 짚어보기]](https://img.hankyung.com/photo/202407/02.32509198.3.jpg)

![K팝 업계에도 '친환경' 바람…폐기물 되는 앨범은 '골칫거리' [연계소문]](https://img.hankyung.com/photo/202206/99.27464274.3.jpg)