이슈+ㅣ셔누도 걸린 사진 불법 조작…음란물 숙주 '딥페이크' 어쩌나

-

기사 스크랩

-

공유

-

댓글

-

클린뷰

-

프린트

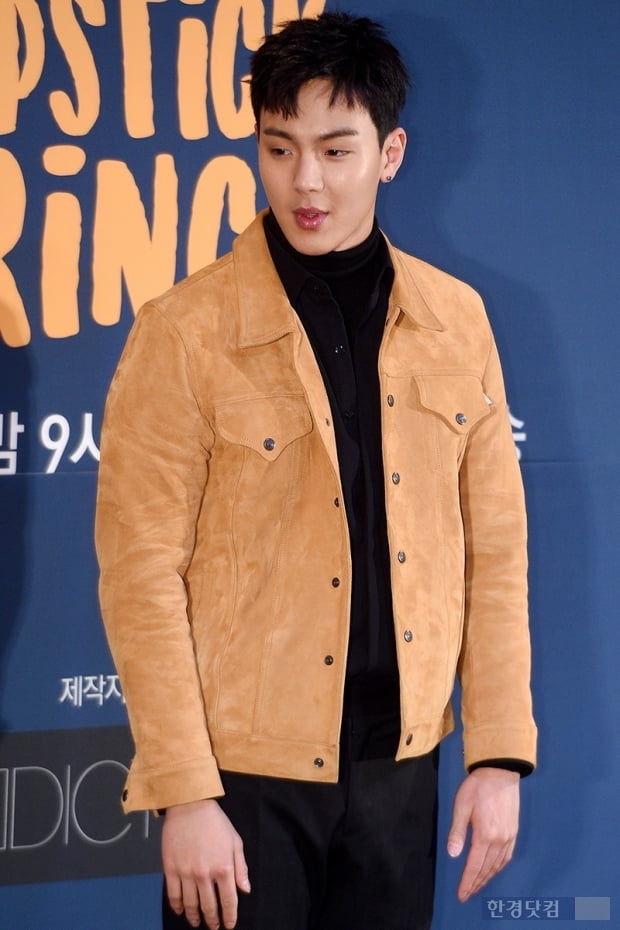

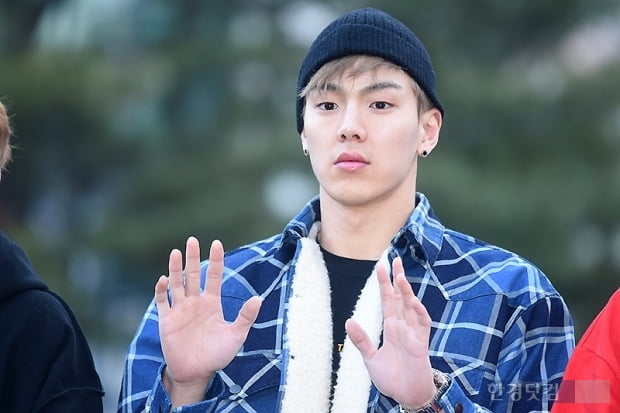

셔누, 불법 조작 사진 유통…성희롱 당해

스타쉽 "셔누 사진 불법적으로 조작, 강경 대응 할 것"

사진 합성→영상물 제작, 딥페이크 기술

음란물 악용 피해 급증

스타쉽 "셔누 사진 불법적으로 조작, 강경 대응 할 것"

사진 합성→영상물 제작, 딥페이크 기술

음란물 악용 피해 급증

3일 온라인을 중심으로 그룹 몬스타엑스 리더 셔누(본명 손현우)의 얼굴이 담긴 남성의 나체 사진이 유포됐다. 해당 이미지를 SNS에 게재한 유포자는 "짤(짧은 영상 이미지)로 올리면 음란물로 잘릴까봐. 진짜진짜 보고싶은 분들만 DM주세요"라는 설명과 함께 성희롱성 표현을 덧붙이기도 했다.

셔누 소속사 스타쉽엔터테인먼트는 즉각 반박했다. 4일 공식입장을 통해 "불법적으로 조작된 사진"이라며 "최초 유포자를 비롯해 사진을 유포하는 이들을 경찰에 신고하고, 성폭력범죄처벌법 위반 및 인격권 침해 등에 대한 민사상 손해배상 청구도 할 예정"이라고 밝혔다.

또 "지속적인 모니터링을 통해 추가적인 피해가 발생하지 않도록 당사 소속 아티스트 보호를 위한 모든 노력을 기울일 것"이라며 "합의 없는 강력한 법적 조치를 계속 진행하도록 하겠다"고 강조했다.

합성 사진으로 음란물이 제작돼 피해를 입은 연예인은 셔누가 처음이 아니다. 여기에 동영상까지 제작해 SNS나 모바일 메신저를 통해 돌려보는 피해사례도 급증하고 있다.

특히 최근엔 합성 신기술 '딥페이크'를 통해 가짜 동영상도 5분이면 제작이 가능해져 더욱 강력하게 법적 조치를 해야 한다는 목소리가 커지고 있다.

과거엔 사진으로 합성한 영상을 만들려면 수많은 프레임을 수정해야 했다. 그러나 최근엔 인공지능(AI) 기술의 발달에 따라 자동으로 얼굴을 인식해 합성 영상을 만들 수 있게 됐다. '짤'을 비롯해 동영상까지 손쉽게 제작할 수 있게 된 것.

실제 한 해외 음란사이트를 분석한 결과 한국 여성연예인을 대상으로 한 딥페이크가 342개나 발견됐다. 대부분이 유명 아이돌로 해외에서 널리 알려진 이들이었다. 여기에 셔누의 불법 조작 사진을 통해 딥페이크의 피해자가 여자 연예인에 국한되지 않는다는 사실이 입증됐다. 남녀 가릴 것 없이 성범죄의 피해자가 될 수 있다는 것.

앞서 스타쉽은 지난 7월 소속 아티스트에 대해 허위사실을 유포하고 성희롱, 명예훼손 등을 한 악플러들을 고소한 바 있다. 고소장은 법무법인을 통해 서울 강남경찰서에 제출했다.

피의자 중 일부는 현재 기소의견으로 검찰에 송치됐으며 민사상 대응도 추가로 진행할 예정이라고 스타쉽은 덧붙였다.

문제는 불법적으로 조작한 음란물을 만들어도 강력한 처벌이 이뤄지지 않는다는 점이다.

현행법상 직접 제작한 음란영상을 상업적 목적으로 제작해 유포할 때 '음란물건제조죄'로 최대 1년 이하의 징역 또는 500만 원 이하의 벌금의 처벌을 받을 수 있다. 그 음란물로 인해 피해자가 나왔다면 '정보통신망 이용 촉진 및 정보보호 등에 관한 법률'에 따라 '사이버 명예훼손' 처벌이 가능하지만 이 역시 최대 7년 이하의 징역 또는 5000만원 이하의 벌금에 불과해 솜방망이 처벌이라는 지적이다.

김소연 한경닷컴 기자 sue123@hankyung.com

기사제보 및 보도자료 newsinfo@hankyung.com

![정다은·한서희, 원호 몬스타엑스 탈퇴에도 "돈 갚아" 저격ing [종합]](https://img.hankyung.com/photo/201910/03.19119942.3.jpg)