빅테크 AI전쟁에…엔비디아 칩 '부르는게 값'

입력

수정

지면A12

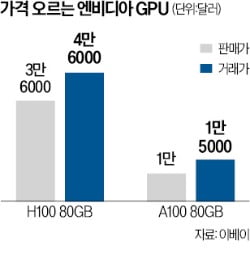

H100 가격 6000만원 달해

챗GPT 등장 후 27% 급등

하위모델인 A100도 상승세

CNBC는 20일 이베이에서 판매되는 H100(80GB) 가격이 지난해 3만6000달러(약 4700만원)에서 최근 4만6000달러(약 6000만원)까지 치솟았다고 보도했다. 챗GPT 등장 이후 27% 넘게 가격이 올랐다. 대규모언어모델(LLM)을 개발하려는 기업이 급증하면서 H100이 ‘귀하신 몸’이 됐다는 게 CNBC의 설명이다.H100은 A100의 뒤를 잇는 엔비디아의 간판 AI 칩이다. H100은 A100 대비 학습 속도가 9배, 언어 추론 속도가 30배 이상 빠르다. 빅테크업체의 AI 기술 경쟁이 치열해지고 있어 H100 수급난은 당분간 계속될 전망이다.

컴퓨팅 장비에 GPU를 얼마나 투입해야 할지를 결정하는 것은 생성형 AI의 파라미터(매개변수) 규모다. 메타(옛 페이스북)가 개발한 라마는 2048개의 A100을 통해 650억 개의 파라미터를 처리하고 있다. 구글 람다는 1370억 개, 네이버 하이퍼클로바는 2040억 개의 파라미터를 활용 중이다. 오픈AI는 GPT-4의 파라미터 수를 공개하지 않았다. 업계에선 이전 모델(GPT-3·1750억 개)보다 30% 이상 많은 파라미터를 썼을 것으로 추정하고 있다.

최진석 기자 iskra@hankyung.com