메타, 오픈소스 AI로 반전 노린다

입력

수정

지면A13

언어모델 '라마' 소스코드 공개

대학·벤처 공략해 영향력 확대

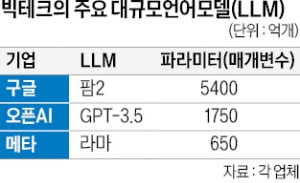

22일 정보기술(IT)업계에 따르면 라마를 활용해 만든 LLM이 속속 등장하고 있다. 이미지 생성 AI로 잘 알려진 스테빌리티AI는 지난달 생성 AI인 스테이블LM을 출시했다. 독일 비영리단체인 오픈어시스턴스도 챗GPT와 비슷한 기능을 갖춘 허깅챗을 내놨다. 스탠퍼드대 연구진이 라마를 기반으로 개발한 알파카, UC버클리-스탠퍼드대 연구진이 만든 비쿠냐 등 소형언어모델(sLLM)도 좋은 평가를 받고 있다.이 AI 모델들은 파라미터(매개변수)가 70억~650억 개에 불과한 라마를 기반으로 개발됐다. 최근 구글이 공개한 LLM 팜2(5400억 개)는 물론 챗GPT를 구동하는 GPT-3.5(1750억 개)와 비교해도 턱없이 적은 수치다. IT업계 관계자는 “매개 변수가 적으면 성능이 떨어지지만 AI 모델을 구축하는 데 걸리는 시간은 줄어든다”며 “엔지니어들이 AI 모델을 개발할 토대를 제공했다는 점에 의미를 둘 수 있다”고 설명했다.

업계에서는 학계를 중심으로 공고해지는 ‘라마 동맹’이 구글과 오픈AI의 대항마 역할을 할 것으로 보고 있다. 메타가 계획대로 라마의 파라미터를 1000억 개로 확대하면 라마 동맹의 경쟁력이 더 강화될 것이란 전망도 나온다.

생성 AI 분야 경쟁사인 구글은 메타의 소스코드 공개에 부정적 견해를 내놨다. 조빈 가라마니 구글 연구부사장은 최근 뉴욕타임스와의 인터뷰에서 “생성 AI는 논란이 많은 분야”라며 “오픈소스 코드 공개에 신중할 필요가 있다”고 지적했다.

최진석 기자 iskra@hankyung.com