친구와 영상통화했는데 7억 털렸다…난리 난 '신종 사기' [조아라의 IT's fun]

입력

수정

[조아라의 IT's fun] 25

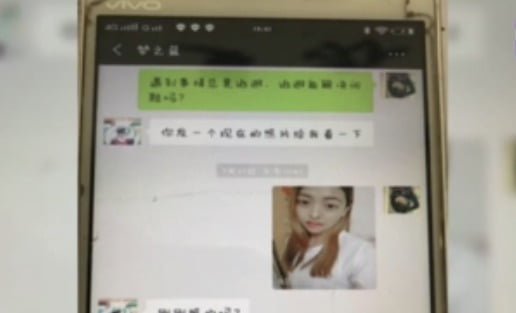

중국의 한 정보기술(IT) 기업 대표 궈모 씨는 친구로부터 걸려온 웨이신 영상 통화를 통해 이같은 메시지를 접했다. 내용은 간단했다. 필요한 돈은 이미 회사 계좌로 보내놨으니 그 돈을 그대로 다시 이체해달라는 내용이었다. 계좌이체 명세서를 캡처(화면 갈무리)해 보낸 친구는 "입찰에 참가하려고 하는데 개인 계좌 말고 회사 계좌로 보증금 430만위안(약 7억8000만원)을 보내야 한다"며 "너희 회사 계좌만 잠시 사용하겠다"고 말했다.간절한 친구의 얼굴과 목소리를 확인한 궈 씨는 10분 만에 두 번에 나눠 전액을 친구가 안내한 계좌로 이체했다. 그는 송금한 뒤 친구에게 "입금 완료"라는 웨이신 메시지를 보냈다. 그러나 되돌아온 답변은 '물음표'였다. 부랴부랴 친구에게 전화를 걸었지만 이같은 사실을 전혀 모르는 친구의 모습에 그제야 사기당한 것을 깨달았다. 궈 씨는 즉시 경찰 신고를 하고 은행 역시 지급정지 조치를 취했지만 송금액 일부인 336만위안(약 6억1000만원)만 되찾을 수 있었다.

최근 중국 후난르바오 등 현지 매체는 "신종 인공지능(AI) 사기가 기승을 부리고 있다"며 이 사건을 대대적으로 보도했다. 궈 씨는 "다짜고짜 돈을 빌려달라고 한 것도 아니고 송금했다며 다시 이체를 부탁한 데다 영상 통화로 친구의 목소리와 얼굴을 확인한 터라 경계심을 풀었다"고 말했다.

정신줄 놓으면 순식간에 털려…진짜 같은 '신종사기' 뭐길래

24일 관련 업계에 따르면 최근 세계적으로 범죄 대상자의 지인을 사칭해 금전을 요구하는 사례가 급증하고 있다. AI 기술 발달로 짧게는 3초 분량의 음성만 있으면 동일한 목소리를 만들어낼 수 있는 음성 생성 AI가 범죄에 악용되고 있다. 여기에 AI 얼굴 합성 기술 '딥페이크'를 결합한 사기 행각이 증가하고 있어 사회적 문제로 대두되고 있다.

"소름끼친다"…충격적인 최근 'AI 딥페이크' 근황

국내 상황도 다르지 않다. 허은아 국민의힘 의원이 방송통신심의위원회(방심위)로부터 제출받은 자료에 따르면 방심위가 시정요구 및 자율규제 조치한 성적 허위 영상물은 2020년 548건에 불과했으나, 2021년 2988건으로 급증했다. 지난해 8월까지는 총 2821건으로 최근 3년 사이 5배 가량 증가했다. 현행 '성폭력처벌법'에 따라 타인의 얼굴이나 신체 등을 허위 성 착취물로 만들거나 배포하면 5년 이하 징역 또는 5000만원 이하의 벌금에 처한다는 규정이 있지만, 실질적으로 발생하는 모든 범죄를 온전히 차단하기 어려운 실정이다.업계 관계자는 "딥페이크 범죄의 경우 온라인을 통해 이뤄진다는 점에서 유포 속도가 빠르고 확산 범위가 상당히 광범위하다"며 "특히 해외에 서버를 두고 유포한 경우 최초 유포자를 찾기는 사실상 쉽지 않다"고 말했다.